Project Syndicate

Η πολεμική αεροπορία των ΗΠΑ προβλέπει ένα μέλλον στο οποίο «οι ειδικές δυνάμεις θα μπορούν να στέλνουν σμήνη μηχανικών εντόμων εφοδιασμένων με βιντεο-κάμερες μέσα σε ένα κτίριο στη διάρκεια μιας ομηρείας».

Μια «εταιρεία μικροσυστημάτων» έχει κατασκευάσει ήδη ένα εξαιρετικά μικροσκοπικό ρομπότ με κάμερα και ραδιοσυχνότητες που μοιάζει με κατσαρίδα και μπορεί να διασχίσει έως και 100 μέτρα. Αποτελεί ένα από τα πολλά «βιομιμητικά» όπλα που ήδη βρίσκονται στον ορίζοντα.

Ποιος ξέρει πόσα άλλα τέτοια πειράματα γίνονται για προηγμένα όπλα. Πρόσφατα ένα βιβλίο περιγράφει τον μελλοντικό πόλεμο Κίνας και Ρωσίας με ευρεία χρήση αυτόνομων drones, λέιζερ και δορυφόρων. Το βιβλίο του Π. Σίνγκερ και του Ογκαστ Κόουλ δεν θεωρείται τεχνολογική φαντασία: Περιλαμβάνει εκατοντάδες σημειώσεις που αποδεικνύουν την ανάπτυξη κάθε τεχνολογίας που περιγράφεται. Ανάμεσα σε αυτά υπάρχουν και ρομπότ-δολοφόνοι σε έναν αγώνα μεταξύ των προηγμένων κρατών για το ποιο θα κατασκευάσει το πιο αποτελεσματικό.

Στο παρελθόν, κράτη συμφώνησαν για να απαγορεύσουν τα ιδιαίτερα τρομακτικά νέα όπλα. Μέχρι τα μέσα του 20ού αιώνα οι διεθνείς συμβάσεις απαγόρευαν τα βιολογικά και χημικά όπλα. Η κοινότητα των εθνών έχει απαγορεύσει επίσης τη χρήση τεχνολογίας λέιζερ που τυφλώνουν.

Ενα ισχυρό δίκτυο μη κυβερνητικών οργανώσεων προέτρεψε με επιτυχία τον ΟΗΕ να καλέσει τα κράτη-μέλη να συμφωνήσουν σε παρόμοια απαγόρευση των ρομπότ-δολοφόνων και άλλων όπλων που μπορούν να δράσουν μόνα τους, αυτόνομα, χωρίς άμεσο ανθρώπινο έλεγχο, για να καταστρέψουν κάποιον στόχο.

Και ενώ υπήρξε συζήτηση για τον ορισμό μιας τέτοιας τεχνολογίας, όλοι μπορούμε να φανταστούμε ορισμένα ιδιαίτερα τρομακτικά είδη όπλων που όλα τα κράτη θα πρέπει να συμφωνήσουν να μην κατασκευάσουν ή να αναπτύξουν ποτέ. Ενα drone που σταδιακά θερμαίνει τους στρατιώτες του εχθρού μέχρι θανάτου θα παραβίαζε τις διεθνείς συμβάσεις κατά των βασανιστηρίων. Τα ηχητικά όπλα που έχουν σχεδιαστεί για να καταστρέψουν την ακοή ή την ισορροπία ενός εχθρού θα πρέπει να έχουν παρόμοια μεταχείριση. Μια χώρα που σχεδίασε και χρησιμοποίησε τέτοια όπλα θα πρέπει να εξοριστεί από τη διεθνή κοινότητα.

Και όμως, μερικοί από τους μεγαλύτερους στρατούς του κόσμου φαίνεται να οδεύουν προς ή να έχουν ξεκινήσει την ανάπτυξη τέτοιων όπλων, ακολουθώντας μια λογική αποτροπής: φοβούνται ότι θα συντριβούν από την τεχνητή νοημοσύνη των αντιπάλων τους εάν δεν μπορούν να απελευθερώσουν μια εξίσου ισχυρή δύναμη. Το κλειδί για την επίλυση μιας τέτοιας επικίνδυνης κούρσας εξοπλισμών μπορεί να βρίσκεται στη προληπτική επανεξέταση του τι μπορεί να χρησιμοποιηθεί ως πολεμική τεχνητή νοημοσύνη.

Καθώς ο «πόλεμος επιστρέφει στο σπίτι», η ανάπτυξη στρατιωτικής δύναμης σε χώρες όπως οι ΗΠΑ και η Κίνα είναι μια αυστηρή προειδοποίηση για τους πολίτες τους: όποιες τεχνολογίες ελέγχου και καταστροφής επιτρέψετε στην κυβέρνησή σας να αγοράσει τώρα για χρήση στο εξωτερικό, μπορεί κάλλιστα να χρησιμοποιηθούν εναντίον σας στο μέλλον.

Οποιαδήποτε προσπάθεια κωδικοποίησης του νόμου και της ηθικής σε ρομπότ-δολοφόνους εγείρει τεράστιες πρακτικές δυσκολίες. Ο καθηγητής Πληροφορικής Νόελ Σάρκι υποστήριξε ότι είναι αδύνατο να προγραμματιστεί ένας στρατιώτης-ρομπότ με αντιδράσεις για καθεμία από τις άπειρες καταστάσεις που θα μπορούσαν να προκύψουν στον πυρετό της σύγκρουσης. Ομως ένα αυτόνομο οπλικό σύστημα μέσα στην ομίχλη του πολέμου είναι επικίνδυνο.

Η τυποποίηση των αντιδράσεων των ρομποτικών όπλων μπορεί να είναι αδύνατη. Η μάθηση των μηχανών λειτουργεί καλύτερα όπου υπάρχει ένα τεράστιο σύνολο δεδομένων με σαφώς κατανοητά παραδείγματα καλού και κακού, σωστού και λάθους. Για παράδειγμα, οι εταιρείες πιστωτικών καρτών έχουν βελτιώσει τους μηχανισμούς ανίχνευσης απάτης με συνεχείς αναλύσεις εκατοντάδων εκατομμυρίων συναλλαγών, όπου τα ψευδώς αρνητικά και τα ψευδώς θετικά επισημαίνονται εύκολα με σχεδόν 100% ακρίβεια. Θα ήταν δυνατόν να αναλυθούν έτσι οι εμπειρίες των στρατιωτών στο Ιράκ, αποφασίζοντας εάν θα πυροβολήσουν άτομα που δεν είναι ξεκάθαρο εάν είναι εχθροί ή άμαχοι;

Δεδομένων αυτών των δυσκολιών, είναι δύσκολο να αποφευχθεί το συμπέρασμα ότι η ιδέα «ηθικών» ρομποτικών μηχανών-δολοφόνων δεν είναι ρεαλιστική και είναι πολύ πιθανό να υποστηρίξει επικίνδυνες φαντασιώσεις πολέμων όπου οι επιτιθέμενοι πατούν απλώς κάποια κουμπιά και αποφεύγονται σφαγές αθώων.

Ο Frank Pasquale είναι καθηγητής στη Νομική του Πανεπιστημίου του Μπρούκλιν στη Νέα Υόρκη με τομέα εξειδίκευσης την Τεχνητή Νοημοσύνη, τους αλγορίθμους και τη ρομποτική εκπαίδευση

Latest News

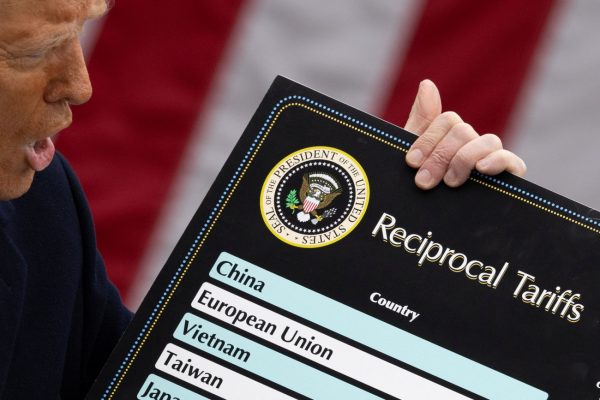

Αναδιάταξη της οικονομικής τάξης

Ο κίνδυνος που ενέχει αυτή η ανορθόδοξη οικονομική πολιτική είναι ότι η προσδοκώμενη αύξηση εσόδων από δασμούς είναι πιθανό να μην αποδώσει

Αναπάντεχη η ανθεκτικότητα στην αγορά κρυπτονομισμάτων – Τί αναμένεται για τη συνέχεια

Σε μια αγορά όπου κυριαρχεί η έντονη μεταβλητότητα, θα περίμενε κανείς να δει υπερβολές μετά από τέτοια αναταραχή στις χρηματαγορές. Κι όμως, φαίνεται ότι οι μεγάλοι πάικτες κρυπτονομισμάτων κάτι περιμένουν.

Η «παγίδα Kindleberger» και η κινεζική απάντηση στους δασμούς Τραμπ

Η ίδια δυναμική που χαρακτήρισε τον πρώτο εμπορικό πόλεμο του Τραμπ εμφανίζεται ξανά

Άμεσες και έμμεσες επιπτώσεις

Η απόφαση του Τραμπ να κλιμακώσει τον εμπορικό πόλεμο έχει άμεσες επιπτώσεις στις διεθνείς αγορές και στις στρατηγικές μεγάλων πολυεθνικών εταιρειών

Θαλάσσιος Χωροταξικός Σχεδιασμός – Στην αφετηρία μιας νέας φάσης στις ελληνοτουρκικές σχέσεις

Ο Κώστας Υφαντής γράφει στο in για το Θαλάσσιο Χωροταξικό Σχεδιασμό και τι θεωρεί η Ελλάδα νομικά διεκδικήσιμο

![Οι αλλαγές που υπάρχουν στα φορολογικά έντυπα για τα εισοδήματα του φορολογικού έτους 2024 από ακίνητα [Β]](https://www.ot.gr/wp-content/uploads/2025/02/akinita15-1-600x400.jpg)

Πώς να συμπληρώσετε το έντυπο Ε2 και Ε1 για τα ακίνητα

Φορολογία εισοδημάτων από ακίνητα και οι αλλαγές στα έντυπα Ε2 και Ε1 για την απεικόνιση των εισοδημάτων από ακίνητα

Η μεγάλη εικόνα

Οι έμμεσες επιπτώσεις του δασμολογικού πολέμου για την ελληνική οικονομία φαίνονται να είναι σημαντικότερες από τις άμεσες

Οι εορτές του Πάσχα και λειτουργία των εμπορικών καταστημάτων

Με την ευκαιρία των εορτών του Πάσχα, κρίνουμε σκόπιμο να αναφερθούμε πως αντιμετωπίζονται από την εργατική νομοθεσία οι ημέρες αυτές

Πώς επηρεάστηκαν τα επενδυτικά καταφύγια από τη διεθνή οικονομική αναταραχή

Η άναρχη και συνάμα επικίνδυνη χάραξη της δασμολογικής πολιτικής των ΗΠΑ προκαλεί έντονη νευρικότητα στους επενδυτές. Κι εκείνοι, ενστικτωδώς αναζητούν χαμηλότερη μεταβλητότητα.

Πώς η λογιστική θα κάνει πιο «πλούσιους» τους φορείς γενικής κυβέρνησης από 1/1/2026;

To 2025 θεωρείται περίοδος προετοιμασίας, ή αλλιώς προπαρασκευαστική περίοδος

![Πλημμύρες: Σημειώθηκαν σε επίπεδα ρεκόρ στην Ευρώπη το 2024 [γράφημα]](https://www.ot.gr/wp-content/uploads/2025/04/FLOOD_HUNGRY-90x90.jpg)

![Airbnb: Πτωτικά κινήθηκε η ζήτηση τον Μάρτιο – Τι δείχνουν τα στοιχεία [γράφημα]](https://www.ot.gr/wp-content/uploads/2024/07/airbnb-gba8e58468_1280-1-90x90.jpg)

![Επιχειρήσεις: Με τι επιτόκιο δανείζονται – Πώς θα ξεκλειδώσει περισσότερη ρευστότητα [γράφημα]](https://www.ot.gr/wp-content/uploads/2025/04/daneia-trapezes-768x432-1-600x338.jpg)

Αριθμός Πιστοποίησης

Αριθμός Πιστοποίησης