Η ανθρωπότητα βρίσκεται στα πρόθυρα μιας νέας εποχής πολέμων.

Καθοδηγούμενες από τις ραγδαίες εξελίξεις στην Τεχνητή Νοημοσύνη, οι πλατφόρμες όπλων που μπορούν να εντοπίσουν, να στοχεύσουν και να αποφασίσουν να σκοτώσουν ανθρώπινα όντα από μόνες τους —χωρίς κάποιος αξιωματικός να διευθύνει την επίθεση ή ένας στρατιώτης να πατήσει τη σκανδάλη— αλλάζουν με ταχύτητα το μέλλον των συγκρούσεων.

Τεχνητή νοημοσύνη: Πώς θα έμοιαζε σήμερα ο Μέγας Αλέξανδρος;

Επισήμως, ονομάζονται θανατηφόρα αυτόνομα οπλικά συστήματα (LAWS), αλλά οι επικριτές τους τα αποκαλούν ρομπότ δολοφόνους. Πολλές χώρες, συμπεριλαμβανομένων των ΗΠΑ, της Κίνας, του Ηνωμένου Βασιλείου, της Ινδίας, του Ιράν, του Ισραήλ, της Νότιας Κορέας, της Ρωσίας και της Τουρκίας, έχουν επενδύσει πολλά στην ανάπτυξη τέτοιων όπλων τα τελευταία χρόνια.

Μια έκθεση των Ηνωμένων Εθνών εκτιμά ότι τα τουρκικής κατασκευής drones Kargu-2 σηματοδότησαν την αυγή αυτής της νέας εποχής, όταν επιτέθηκαν σε μαχητές στη Λιβύη το 2020 εν μέσω της συνεχιζόμενης σύγκρουσης στη χώρα.

Τα αυτόνομα μη επανδρωμένα αεροσκάφη διαδραμάτισαν επίσης κρίσιμο ρόλο στον πόλεμο στην Ουκρανία, όπου τόσο η Μόσχα όσο και το Κίεβο έχουν αναπτύξει αυτά τα όπλα χωρίς πληρώματα για να στοχεύσουν εχθρικούς στρατιώτες και υποδομές.

Η μεγάλη δημόσια συζήτηση

Η εμφάνιση και η ανάπτυξη τέτοιων μηχανών έχουν προκαλέσει έντονες συζητήσεις μεταξύ ειδικών, ακτιβιστών και διπλωματών σε παγκόσμιο επίπεδο, καθώς ανταλλάσσουν επιχειρήματα για τα πιθανά οφέλη και τους ενδεχόμενους κινδύνους από τη χρήση ρομπότ. Ταυτόχρονα το ερώτημα για το εάν πρέπει να τις φρενάρουν εδώ και τώρα ανεβάζει την ένταση και παραμένει χωρίς απάντηση.

Ωστόσο, σε ένα ολοένα και πιο διχασμένο γεωπολιτικό τοπίο, μπορεί η διεθνής κοινότητα να φτάσει σε οποιαδήποτε συναίνεση γι’ αυτές τις μηχανές; Μπορούν οι ηθικές, νομικές και τεχνολογικές απειλές που θέτουν τέτοια όπλα να τα βάλουν στον πάγο πριν κυριαρχήσουν στο πεδίο της μάχης; Είναι εφικτή μια γενική απαγόρευση ή η εισαγωγή μιας δέσμης κανονισμών αποτελεί μια πιο ρεαλιστική επιλογή; Εκτενές σχετικό άρθρο του Al Jazeera καταπιάστηκε με αυτά τα ερωτήματα, τα έθεσε σε κορυφαίους ειδικούς του συγκεκριμένου τομέα και πήρε κάποιες απαντήσεις που δίνουν τροφή για σκέψη.

Μια πρώτη σύντομη απάντηση είναι ότι η πλήρης απαγόρευση των αυτόνομων οπλικών συστημάτων δεν φαίνεται πιθανή σύντομα. Ο κόσμος διχάζεται ανάμεσα σε αυτούς που πιστεύουν ότι επιβάλλεται η εισαγωγή πολλών κανονισμών που θα «ακυρώνουν» επί της ουσίας το βεληνεκές της χρήσης τους και όσους «γλυκαίνονται» από τις υποσχέσεις σίγουρης νίκης που κομίζουν.

Η Γιασμίν Αφίνα, συνεργάτης ερευνήτρια στη δεξαμενή σκέψης Chatham House με έδρα το Λονδίνο, παρουσίασε μόλις το Μάρτιο στη Βουλή των Κοινοτήτων, πως η Υπηρεσία Εθνικής Ασφαλείας των ΗΠΑ (NSA) αναγνώρισε κάποια στιγμή λανθασμένα δημοσιογράφο του Al Jazeera για μεταφορέα της Αλ Κάιντα. Το συμβάν, που οδήγησε στο να μπει το όνομα του προαναφερόμενου δημοσιογράφου στη λίστα με τα άτομα ενδιαφέροντος των ΗΠΑ, αποκαλύφθηκε από τη διαρροή εγγράφων του 2013 από τον Έντουαρντ Σνόουντεν, που εργαζόταν με συμβόλαιο στην NSA.

Το σύστημα επιτήρησης πίσω από το συμβάν δεν είναι φονικό, ωστόσο μπορεί να επιφέρει τον θάνατο, στη συγκεκριμένη περίπτωση του δημοσιογράφου, σε άλλες περιστάσεις πολλών άλλων, επιχειρηματολόγησε η Αφίνα.

Μαζικοί θάνατοι;

Η πιθανότητα τα LAWSνα να πυροδοτήσουν μια σειρά κλιμακούμενων γεγονότων με κατάληξη μαζικούς θανάτους ανησύχησε τον Τόμπι Γουέλς, ειδικό στην Τεχνητή Νοημοσύνη στο πανεπιστήμιο New South Wales στο Σίδνεϊ της Αυστραλίας. «Ξέρουμε τι συμβαίνει όταν βάζουμε περίπλοκα ηλεκτρονικά συστήματα το ένα εναντίον του άλλου σε ένα αβέβαιο και ανταγωνιστικό περιβάλλον. Ονομάζεται… χρηματιστήριο», έγραψε ο ίδιος σε αναφορά του στη Βουλή των Λόρδων.

Αυτό όμως δεν σημαίνει, κατά τον ίδιο, ότι πρέπει οι ερευνητές να σταματήσουν να αναπτύσσουν την τεχνολογία που είναι πίσω από τα αυτόματα οπλικά συστήματα, καθώς μπορεί να έχει σημαντικά οφέλη σε άλλα πεδία.

Για παράδειγμα, ο ίδιος αλγόριθμος χρησιμοποιείται στα συστήματα ασφαλείας των αυτοκινήτων για να αποφεύγεται η σύγκρουση τους με τους πεζούς. «Θα ήταν ηθικά λάθος να αρνούμαστε στον κόσμο την ευκαιρία να μειώσουμε τα τροχαία στους δρόμους», συνεχίζει ο ίδιος.

Μια πιθανότητα θα ήταν η προσέγγιση τους με τον ίδιο τρόπο που περιορίστηκαν τα χημικά όπλα, δηλαδή μέσω της Σύμβασης για τα Χημικά Όπλα των Ηνωμένων Εθνών, που εμποδίζει την ανάπτυξη, την παραγωγή, τη συσσώρευση και τη χρήση τους. «Δεν μπορούμε να βάλουμε τη Πανδώρα μέσα στο κουτί, αλλά αυτά τα μέτρα έχουν καταφέρει σε γενικό πλαίσιο να περιορίσουν τη λανθασμένη χρήση στα πεδία σε όλο τον κόσμο», καταλήγει.

Τα οφέλη της Τεχνητής Νοημοσύνης

Επί της ουσίας, τα αυτόνομα οπλικά συστήματα που καθορίζονται από την Τεχνητή Νοημοσύνη έχουν μεγάλα οφέλη από στρατιωτικής άποψης. Για παράδειγμα μπορούν να διεκπεραιώσουν κάποιες αποστολές χωρίς τη χρήση στρατιωτών, μειώνοντας κατά αυτόν τον τρόπο τις απώλειες.

Οι υποστηρικτές τους υπερτονίζουν ότι αυτά τα συστήματα μπορούν επίσης να ελαττώσουν τα ανθρώπινα λάθη στη λήψη αποφάσεων και να εκμηδενίσουν τις προκαταλήψεις, ενώ η ακρίβεια τους μπορεί, τουλάχιστον θεωρητικά, να μειώσει τις απώλειες.

Για κάποιους άλλους ειδικούς ωστόσο, οι κίνδυνοι από τα LAWS ξεπερνούν τα πλεονεκτήματα της χρήσης τους, καθώς οι πιθανές τεχνικές δυσλειτουργίες, οι παραβιάσεις των διεθνών νόμων και οι ηθικές ανησυχίες για τα μηχανήματα που παίρνουν αποφάσεις για τη ζωή και τον θάνατο δεν μπορούν να αγνοηθούν.

Και ποιος είναι υπόλογος;

Στο κέντρο όλων αυτών είναι το καυτό ερώτημα για το ποιος φέρει την ευθύνη για ότι κακό συμβεί, δηλαδή ποιος θα είναι υπόλογος σε μια αστοχία τους με καταστροφικά αποτελέσματα.

Για παράδειγμα, αν τα ρομπότ διαπράξουν ένα έγκλημα πολέμου, θα κληθεί σε απολογία ο επικεφαλής αξιωματικός που παρακολουθεί τη σύγκρουση ή ο ανώτερος του που αποφάσισε την εμπλοκή των μηχανών σε πρώτη φάση; Μήπως τελικά αυτός που πρέπει να καθίσει στο εδώλιο είναι αυτός που τις κατασκεύασε;

Όλα αυτά «αντιπροσωπεύουν ένα μεγάλο κενό στην πολιτική συζήτηση για το θέμα», συμπληρώνουν οι ερευνητές Βίντσεντ Μπουλάνιν και Μάρτα Μπο του Διεθνούς Ερευνητικού Ινστιτούτου για την Ειρήνη της Στοκχόλμης (SIRPI).

Για τους ίδιους αυτό που χρειάζεται είναι «η συγκεκριμενοποίηση ποιου ακριβώς όπλου ή σεναρίου μπορεί να αποδειχτεί προβληματικό».

Με απλά λόγια πρέπει να καταρτιστούν δύο διαφορετικές σειρές κανονισμών βάσει των οποίων κάποια θα καταργηθούν και άλλα θα χρησιμοποιηθούν αρκεί να καλύπτουν συγκεκριμένα στάνταρντ στη χρήση τους.

Ανθρώπινη αξιοπρέπεια

«Η ερώτηση του ενός εκατομμυρίου δολαρίων είναι ποια από αυτά μπορούν να χωρέσουν και στα δύο καλάθια».

Σε κάθε περίπτωση, για τον Γουέλς, που προσπερνά αν οι κανονισμοί πρέπει να είναι πολιτικοί ή νομικοί και την έλλειψη εμπιστοσύνης ανάμεσα στα διάφορα κράτη, το βασικότερο όλων των προβλημάτων είναι ότι τις κρίσιμες αποφάσεις στα πεδία των μαχών θα λαμβάνουν οι μηχανές που υπολείπονται ανθρώπινης ενσυναίσθησης.

«Είναι ασέβεια προς την ανθρώπινη αξιοπρέπεια», καταλήγει ο ίδιος.

Latest News

Στις συμπληγάδες ΗΠΑ - Κίνας ο γίγαντας των ημιαγωγών Nvidia - Τι ζητά ο Χουάνγκ στο Πεκίνο;

Ο Τζένσεν Χουάνγκ, CEO της Nvidia, θα απαιτήσει άδειες για να εξάγει το μικροτσίπ H20 AI στην Κίνα

Ιταλική εφημερίδα δημοσίευσε ένθετο γραμμένο από ΑΙ

Μετά τον πρώτο μήνα δοκιμών, η ιταλική εφημερίδα Il Foglio προσέλαβε το σύστημα ως μόνιμο υπάλληλο.

Η Δικαιοσύνη αναβαθμίζεται ψηφιακά με συστήματα AI

Μέχρι σήμερα, η μετάφραση εκατοντάδων, αν όχι χιλιάδων, σελίδων και η αναζήτηση διαθέσιμων μεταφραστών και διερμηνέων, ειδικά σε κάποιες γλώσσες, προκαλεί σημαντικές καθυστερήσεις

Ξεκινά η υλοποίηση του ελληνικού εργοστασίου τεχνητής νοημοσύνης

Το AI Factory «Pharos» είναι ένα από τα πρώτα δεκατρία «εργοστάσια» Τεχνητής Νοημοσύνης στην Ευρώπη

Η TDK φέρνει επανάσταση στη δημιουργική ΑΙ

Η TDK κατέγραψε χρόνους απόκρισης 20 τρισεκατομμυρίων του δευτερολέπτου στη δοκιμή για τη βελτίωση των ταχυτήτων μεταφοράς δεδομένων

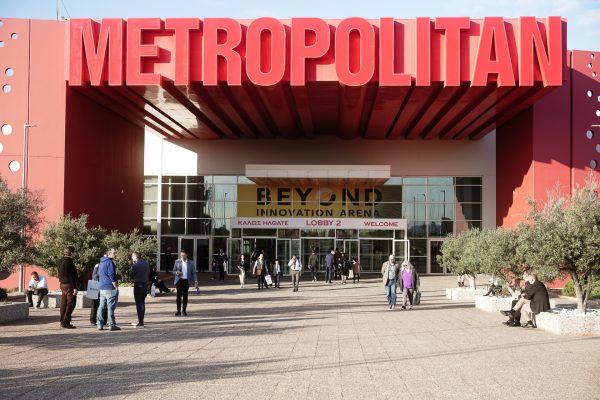

Ξεπέρασαν τις 15.000 οι επισκέπτες στη Beyond 2025

Η BEYOND 2025 συγκέντρωσε περισσότερους από 300 εκθέτες από την Ελλάδα και από 10 χώρες

Οι start-ups που δημιουργούν εργαλεία παραγωγικότητας είναι το νέο μεγάλο στοίχημα της ΑΙ - Ποιες είναι

Οι επενδυτές ποντάρουν σε AI startups που αναπτύσσουν πρακτικές εφαρμογές της ΑΙ αναζητώντας μεγάλα κέρδη χωρίς τεράστιες δαπάνες

Τα 5 πράγματα που δεν πρέπει να μοιράζεστε ποτέ με την τεχνητή νοημοσύνη

To ChatGPT, όπως και άλλα εργαλεία τεχνητής νοημοσύνης, εξελίσσονται χρησιμοποιούνται από όλο και περισσότερους ανθρώπους για μια ευρεία γκάμα αναζητήσεων

Ποιες είναι οι 10 χώρες με τα περισσότερα ταλέντα στην AI

Έρευνα της Microsoft, με τη συμμετοχή 31.000 ατόμων σε 31 χώρες, έδειξε ότι το 66% των επιχειρήσεων δεν θα προσλάμβανε κάποιον χωρίς δεξιότητες στην τεχνητή νοημοσύνη

Η συμβολή της ΑΙ στην κατανόηση της σεισμικής κρίσης στη Σαντορίνη

Τα πρώτα αποτελέσματα της χρήση υψηλής τεχνολογίας και τεχνητής νοημοσύνης στην παρακολούθηση της σεισμικής δραστηριότητας στη Σαντορίνη

![Πλημμύρες: Σημειώθηκαν σε επίπεδα ρεκόρ στην Ευρώπη το 2024 [γράφημα]](https://www.ot.gr/wp-content/uploads/2025/04/FLOOD_HUNGRY-90x90.jpg)

![Airbnb: Πτωτικά κινήθηκε η ζήτηση τον Μάρτιο – Τι δείχνουν τα στοιχεία [γράφημα]](https://www.ot.gr/wp-content/uploads/2024/07/airbnb-gba8e58468_1280-1-90x90.jpg)

![Χρυσές λίρες: Φρενίτιδα χωρίς τέλος – Πόσες πούλησαν και αγόρασαν οι Έλληνες [πίνακες]](https://www.ot.gr/wp-content/uploads/2022/12/xrises-lires-600x300.jpg)

Αριθμός Πιστοποίησης

Αριθμός Πιστοποίησης