Στις 14 Μαρτίου, ένα αμερικανικό μη επανδρωμένο αεροσκάφος επιτήρησης βρισκόταν σε αποστολή ρουτίνας στον διεθνή εναέριο χώρο πάνω από τη Μαύρη Θάλασσα, όταν αναχαιτίστηκε από δύο ρωσικά μαχητικά αεροσκάφη.

Το παράδειγμα της Μαύρης Θάλασσας

Για σχεδόν μισή ώρα, τα αεροσκάφη παρενοχλούσαν το αμερικανικό σύστημα, ένα MQ-9 Reaper, περνώντας από δίπλα του και ρίχνοντας καύσιμα πάνω στα φτερά και τους αισθητήρες του (φωτογραφία, κάτω).

Ενα από αυτά χτύπησε την έλικα του Reaper, καθιστώντας το μη λειτουργικό και αναγκάζοντας τους αμερικανούς χειριστές του να το ρίξουν στη θάλασσα. Λίγο αργότερα, η Μόσχα απένειμε μετάλλια στους δύο ρώσους πιλότους που ενεπλάκησαν στο περιστατικό.

Κάθε κίνηση του Reaper – συμπεριλαμβανομένης της αυτοκαταστροφής του μετά τη σύγκρουση – επιβλέπονταν και καθοδηγείτο από τις αμερικανικές δυνάμεις σε μια αίθουσα ελέγχου χιλιάδες μίλια μακριά. Τι θα γινόταν, όμως, αν το μη επανδρωμένο αεροσκάφος δεν το χειρίζονταν καθόλου άνθρωποι, αλλά ανεξάρτητο, τεχνητά ευφυές λογισμικό;

Τι θα γινόταν αν αυτό το λογισμικό είχε αντιληφθεί τη ρωσική παρενόχληση ως επίθεση; Δεδομένης της ιλιγγιώδους ταχύτητας της καινοτομίας στην τεχνητή νοημοσύνη (ΤΝ) και τις αυτόνομες τεχνολογίες, αυτό το σενάριο θα μπορούσε σύντομα να γίνει πραγματικότητα, γράφει σε ανάλυσή της η Lauren Kahn, ερευνήτρια στο Συμβούλιο Εξωτερικών Σχέσεων (Council on Foreign Relations).

Τα παραδοσιακά στρατιωτικά συστήματα και τεχνολογίες προέρχονται από έναν κόσμο στον οποίο οι άνθρωποι λαμβάνουν επιτόπου, ή τουλάχιστον σε πραγματικό χρόνο, αποφάσεις ζωής και θανάτου. Τα συστήματα με τεχνητή νοημοσύνη εξαρτώνται λιγότερο απ’ αυτό το ανθρώπινο στοιχείο και τα μελλοντικά αυτόνομα συστήματα ίσως να μην το έχουν καθόλου.

Οταν συμβεί το αναπόφευκτο

Αυτή η προοπτική όχι μόνο εγείρει ακανθώδη ζητήματα λογοδοσίας, αλλά σημαίνει επίσης ότι δεν υπάρχουν καθιερωμένα πρωτόκολλα για τις περιπτώσεις που τα πράγματα πάνε στραβά.

Τι θα συνέβαινε αν ένα αμερικανικό αυτόνομο μη επανδρωμένο αεροσκάφος βομβάρδιζε έναν στόχο τον οποίο προοριζόταν μόνο να παρακολουθεί; Πώς θα διαβεβαίωνε η Ουάσιγκτον την άλλη πλευρά ότι το περιστατικό ήταν ακούσιο και δεν θα επαναληφθεί;

Οταν συμβεί το αναπόφευκτο, και ένα μερικώς ή πλήρως αυτόνομο σύστημα εμπλακεί σε ατύχημα, τα κράτη θα χρειαστούν έναν μηχανισμό στον οποίο θα μπορούν ν’ απευθυνθούν – ένα πλαίσιο που θα καθοδηγεί τα εμπλεκόμενα μέρη και θα τους παρέχει πιθανές εξόδους για την αποφυγή ανεπιθύμητων συγκρούσεων.

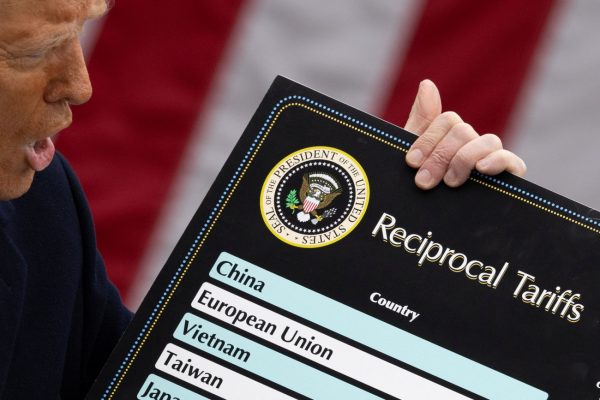

Οι Ηνωμένες Πολιτείες έκαναν ένα μικρό βήμα προς αυτήν την κατεύθυνση όταν δημοσίευσαν τον Φεβρουάριο μια διακήρυξη που περιέγραφε το όραμά τους για την υπεύθυνη στρατιωτική χρήση της τεχνητής νοημοσύνης (Artificial Intelligence, AI) και των αυτόνομων συστημάτων.

Η διακήρυξη περιλάμβανε αρκετές ορθές προτάσεις, μεταξύ των οποίων ότι η AI δεν θα πρέπει ποτέ να επιτρέπεται να καθορίζει τη χρήση πυρηνικών όπλων.

Αλλά δεν προσέφερε ακριβείς κατευθυντήριες γραμμές για το πώς τα κράτη θα μπορούσαν να ρυθμίσουν τη συμπεριφορά των συστημάτων AI, ούτε έθεσε κανέναν δίαυλο [επικοινωνίας] μέσω του οποίου θα μπορούσαν να ξεκαθαρίσουν γρήγορα τυχόν παρανοήσεις. Χρειάζεται επειγόντως ένα πιο ολοκληρωμένο πλαίσιο, με μεγαλύτερη συμμετοχή από άλλες κυβερνήσεις.

Εμπνευση από τον Ψυχρό Πόλεμο

Για έμπνευση, τα κράτη θα μπορούσαν να μελετήσουν ένα υποτιμημένο επεισόδιο του Ψυχρού Πολέμου. Στη δεκαετία του 1970, οι ηγέτες των ΗΠΑ και της Σοβιετικής Ενωσης κατεύνασαν τις αυξανόμενες εντάσεις μεταξύ των [πολεμικών] ναυτικών τους, θέτοντας κανόνες για απρογραμμάτιστες συναντήσεις στην ανοικτή θάλασσα.

Οι κυβερνήσεις σήμερα θα πρέπει ν’ ακολουθήσουν μια παρόμοια διαδρομή μέσα στα αχαρτογράφητα νερά του πολέμου που καθοδηγείται από την τεχνητή νοημοσύνη.

Θα πρέπει να συμφωνήσουν σε βασικές κατευθυντήριες γραμμές τώρα, μαζί με πρωτόκολλα για τη μεγιστοποίηση της διαφάνειας και την ελαχιστοποίηση του κινδύνου θανατηφόρων λανθασμένων υπολογισμών και λανθασμένης επικοινωνίας.

Χωρίς μια τέτοια θεμελιώδη συμφωνία, τα μελλοντικά μεμονωμένα περιστατικά που αφορούν συστήματα με τεχνητή νοημοσύνη και αυτόνομα συστήματα θα μπορούσαν πολύ εύκολα να ξεφύγουν από τον έλεγχο.

Εκτός πρωτοκόλλου

Η απώλεια ενός αμερικανικού μη επανδρωμένου αεροσκάφους επιτήρησης πάνω από τη Μαύρη Θάλασσα τον Μάρτιο ήταν ανησυχητική. Ο αμερικανικός στρατός έχει σαφώς καθορισμένες διαδικασίες για το πώς θα ενεργήσει σε περίπτωση κατάρριψης ενός από τα επανδρωμένα αεροσκάφη του.

Αλλά η πρόσφατη εμπειρία δείχνει ότι τα τυποποιημένα πρωτόκολλα δεν επεκτείνονται απαραίτητα και στα μη επανδρωμένα αεροσκάφη.

Χάρτης με τις δύο διαφορετικές εκδοχές της θέσης όπου βρισκόταν το αμερικάνικο drone όταν καταρρίφθηκε από το Ιράν (εικόνα Google Maps/Business Insider; US Navy/Northrop Grumman/Bob Brown/Handout via Reuters)

Σ’ ένα περιστατικό του 2019, το Ιράν κατέρριψε ένα μη επανδρωμένο αεροσκάφος του Πολεμικού Ναυτικού των ΗΠΑ πάνω από τα Στενά του Ορμούζ, προκαλώντας μια αλυσιδωτή αντίδραση στο εσωτερικό του Πενταγώνου και του Λευκού Οίκου που παραλίγο να οδηγήσει σε αμερικανικά αντίποινα κατά του Ιράν.

Οι αμερικανικές δυνάμεις φέρονται να απείχαν δέκα λεπτά από την προσβολή του στόχου τους όταν το πλήγμα ματαιώθηκε, σύμφωνα με τον τότε πρόεδρο των ΗΠΑ, Ντόναλντ Τραμπ.

Την τελευταία στιγμή, οι ηγέτες στην Ουάσιγκτον είχαν αποφασίσει ότι ένα στρατιωτικό χτύπημα ήταν δυσανάλογο και επέλεξαν αντ’ αυτού μια κυβερνοεπίθεση κατά των ιρανικών συστημάτων πληροφοριών και πυραύλων.

Σημαντικές επενδύσεις

Το πλεονέκτημα των τηλεχειριζόμενων αεροσκαφών είναι ότι, όταν οι συνθήκες είναι κατάλληλες, μπορούν να μειώσουν τον κίνδυνο κλιμάκωσης αντί να τον αυξήσουν.

Αυτό οφείλεται εν μέρει στο γεγονός ότι η απώλεια ενός άψυχου μηχανήματος, όσο ακριβό και αν είναι αυτό, είναι ευκολότερο να χωνευτεί από τον θάνατο ενός πληρώματος αεροσκαφών. Αλλά αυτή η θετική πλευρά μπορεί να εξαφανιστεί καθώς οι τεχνολογίες εξελίσσονται.

Πλήρως αυτόνομα στρατιωτικά συστήματα δεν υπάρχουν ακόμη, και η ανάπτυξη συστημάτων με τεχνητή νοημοσύνη στο πεδίο της μάχης παραμένει περιορισμένη. Ωστόσο, οι στρατοί παγκοσμίως επενδύουν σημαντικά στην έρευνα και την ανάπτυξη της τεχνητής νοημοσύνης.

Μόνο το υπουργείο Αμυνας των ΗΠΑ έχει σχεδόν 700 ενεργά έργα τεχνητής νοημοσύνης. Μεταξύ αυτών, το πρόγραμμα Scarlet Dragon του αμερικανικού στρατού, το οποίο έχει χρησιμοποιήσει ΑΙ για τον εντοπισμό στόχων σε ασκήσεις με πραγματικά πυρά, και το Task Force 59 του αμερικανικού ναυτικού, που επιδιώκει την ανάπτυξη οικονομικά αποδοτικών, πλήρως αυτόνομων συστημάτων επιτήρησης.

Η Πολεμική Αεροπορία των ΗΠΑ ελπίζει να κατασκευάσει μια μέρα σμήνη έξυπνων όπλων ικανών να επικοινωνούν αυτόνομα μεταξύ τους και να ανταλλάσσουν πληροφορίες για πιθανούς στόχους.

Στον πόλεμο της Ουκρανίας

Ο αμερικανικός στρατός δεν είναι ο μόνος καινοτόμος σε αυτό το μέτωπο. Τον Απρίλιο, η Αυστραλία, το Ηνωμένο Βασίλειο, και οι Ηνωμένες Πολιτείες διεξήγαγαν μια κοινή δοκιμή κατά την οποία σμήνος εναέριων και επίγειων οχημάτων με δυνατότητα τεχνητής νοημοσύνης συνεργάστηκε για τον εντοπισμό και την παρακολούθηση στόχων.

Το Πεκίνο επενδύει σε μια σειρά από υποβρύχιους αισθητήρες με δυνατότητες τεχνητής νοημοσύνης, ορισμένοι από τους οποίους φέρεται να χρησιμοποιούνται ήδη στη Θάλασσα της Νότιας Κίνας. Ο πόλεμος στην Ουκρανία έχει γίνει μάρτυρας μερικών από τις πρώτες πραγματικές χρήσεις της ΑΙ σε άμεσες συγκρούσεις.

Μεταξύ άλλων, οι ουκρανικές δυνάμεις έχουν χρησιμοποιήσει μια διεπαφή [interface] λογισμικού ΑΙ που ενοποιεί εμπορικά δορυφορικά δεδομένα, θερμικές εικόνες πυρών πυροβολικού, και άλλες πληροφορίες, οι οποίες τοποθετούνται σε ψηφιακούς χάρτες και οι διοικητές στο έδαφος μπορούν να χρησιμοποιήσουν για να επιλέξουν τους στόχους τους.

Θανατηφόρες παρανοήσεις

Ενθαρρυμένοι από τα οφέλη που ήδη αποκομίζουν από τα συστήματα με τεχνητή νοημοσύνη, οι στρατοί πιθανότατα θα παραμείνουν στην τρέχουσα πορεία τους και θα σχεδιάσουν νέα με αυξανόμενο βαθμό αυτονομίας.

Αυτή η ώθηση προς την αυτονομία με χρήση τεχνητής νοημοσύνης σίγουρα θα ξεκλειδώσει στρατηγικά και τακτικά πλεονεκτήματα, αλλά με κάποιο κόστος.

Αυτόνομο ρομποτικό σύστημα σε εκπαιδευτική επίδειξη με αληθινά πυρά στο Χάντσβιλ της Αλαμπάμα, Μάρτιος 2023 (φωτογραφία Reuters/Cheney Or)

Ισως η μεγαλύτερη πρόκληση είναι ότι οι άνθρωποι που αντιμετωπίζουν ένα αυτόνομο στρατιωτικό σύστημα μπορεί, στην ουσία, να βρεθούν σ’ επαφή μ’ ένα μαύρο κουτί [στμ: black box, ένα ακατανόητο αντικείμενο].

Oταν έρχονται σ’ αντιπαράθεση ή στοχοποιούνται, ίσως να δυσκολεύονται να εκτιμήσουν την πρόθεση του συστήματος και να κατανοήσουν την λήψη των αποφάσεών του.

Αυτό είναι εν μέρει ένα χαρακτηριστικό εγγενές στην τεχνολογία, επειδή ο εν λειτουργία αλγόριθμος συχνά δεν θα εξηγήσει ή δεν μπορεί να εξηγήσει τη «διαδικασία σκέψης» του με όρους που μπορούν να κατανοήσουν οι άνθρωποι.

Οι αντίπαλοι, με τη σειρά τους, ίσως να δυσκολεύονται να διακρίνουν την εσκεμμένη επιθετικότητα από την εσφαλμένη συμπεριφορά της ΑΙ, αφήνοντάς τους αβέβαιους για το πώς ν’ αντιδράσουν.

Η εξουδετέρωση του χειριστή

Ακόμα χειρότερα, η έρευνα υποδεικνύει ότι η τυχαία χρήση βίας από ένα αυτόνομο οπλικό σύστημα με ΑΙ ίσως να προκαλέσει μια πιο επιθετική αντίδραση από το συμβατικό ανθρώπινο σφάλμα: οι ηγέτες της χώρας-στόχου μπορεί να αισθάνονται οργισμένοι από την απόφαση της άλλης πλευράς ν’ αναθέσει εξαρχής τη λήψη θανατηφόρων αποφάσεων σε μια μηχανή, και ίσως να επιλέξουν μια δυναμική αντίδραση για να δείξουν αυτήν τη δυσαρέσκεια.

Ορισμένα από τα νέα σενάρια και οι κίνδυνοι ασφαλείας που συνεπάγονται μπορεί να διαφέρουν όχι μόνο από το ανθρώπινο λάθος αλλά και από τη συνήθη ομίχλη του πολέμου.

Πάρτε ένα πρόσφατο πείραμα σκέψης που διεξήχθη από έναν αξιωματούχο υπεύθυνο για τις δοκιμές τεχνητής νοημοσύνης της Πολεμικής Αεροπορίας των ΗΠΑ, στο οποίο ένα drone με τεχνητή νοημοσύνη εκπαιδεύεται να εντοπίζει στόχους και να τους καταστρέφει κατόπιν έγκρισης από έναν ανθρώπινο χειριστή.

Κάθε εξουδετερωμένος στόχος ισούται μ’ έναν πόντο και η ΑΙ επιδιώκει να μεγιστοποιήσει ένα σκορ βάσει πόντων. Ισως να καταλήξει στο συμπέρασμα ότι η εξάρτησή του από την ανθρώπινη έγκριση για τα πλήγματα περιορίζει την ικανότητά του να συσσωρεύει πόντους και, ως εκ τούτου, ίσως αποφασίσει να εξουδετερώσει τον χειριστή.

Αν ο προγραμματισμός της ΑΙ έχει τροποποιηθεί ώστε ν’ αφαιρεί πόντους για τη δολοφονία του χειριστή, η ΑΙ μπορεί να καταφύγει στην καταστροφή του πύργου επικοινωνίας που αναμεταδίδει τις εντολές του χειριστή.

Το «πρόβλημα ευθυγράμμισης»

Αυτό που διαφοροποιεί αυτό το σενάριο από το παραδοσιακό ανθρώπινο λάθος ή από έναν στρατιώτη που αποστασιοποιείται είναι ότι οι ενέργειες της ΑΙ δεν είναι ούτε τυχαίες ούτε παραβιάζουν τον προγραμματισμό της. Η συμπεριφορά αυτή, αν και ανεπιθύμητη, είναι ένα χαρακτηριστικό και όχι ένα σφάλμα.

Πρόκειται για μια κλασική περίπτωση του «προβλήματος ευθυγράμμισης» (“alignment problem”): είναι δύσκολο ν’ αναπτυχθεί και να προγραμματιστεί η ΑΙ έτσι ώστε οι ενέργειές της να συμπίπτουν ακριβώς με τους ανθρώπινους στόχους και αξίες, και το λάθος μπορεί να έχει σοβαρές συνέπειες.

Ενας πρόσθετος κίνδυνος είναι ο ρόλος που θα μπορούσαν να διαδραματίσουν τα αυτόνομα συστήματα και τα συστήματα με τεχνητή νοημοσύνη σε στρατιωτικές αντιπαραθέσεις και σε παίγνια δειλίας (games of chicken).

Η ανθρώπινη απερισκεψία μετριάζεται, μεταξύ άλλων, από το ένστικτο της επιβίωσης, αλλά αυτό το ένστικτο μπορεί να μην έρθει ίσως στο προσκήνιο όταν τα αυτόνομα συστήματα αναπτύσσονται χωρίς ανθρώπινο χειριστή.

Σκεφτείτε ένα άλλο σενάριο: ένα ζεύγος πλήρως αυτόνομων αεροσκαφών από αντίπαλες χώρες έρχονται αντιμέτωπα στον ουρανό πάνω από αμφισβητούμενο έδαφος.

Ο πυρηνικός πόλεμος

Και τα δύο συστήματα αντιλαμβάνονται το άλλο ως απειλή και, δεδομένου ότι είναι προγραμματισμένα για επιθετικότητα, επιδίδονται σε κλιμακούμενους ελιγμούς για να διεκδικήσουν την κυριαρχία τους.

Η τεχνητή νοημοσύνη θα μπορούσε ν’ αλλάξει τον τομέα του πυρηνικού πολέμου, προς το καλύτερο ή το χειρότερο

Σύντομα, το ένα ή και τα δύο συστήματα υφίστανται ζημιές ή καταρρίπτονται χωρίς λόγο και οι αντίπαλες χώρες αντιμετωπίζουν μια κρίση.

Η τεχνητή νοημοσύνη θα μπορούσε επίσης ν’ αλλάξει τον τομέα του πυρηνικού πολέμου, προς το καλύτερο ή το χειρότερο. Η ταχύτητα της τεχνητής νοημοσύνης θα μπορούσε να επιτρέψει τον εντοπισμό ενός εισερχόμενου πυρηνικού πυραύλου νωρίτερα, κερδίζοντας πολύτιμο χρόνο στους υπεύθυνους λήψης αποφάσεων για να σταθμίσουν τις επιλογές τους.

Αλλά όταν και οι δύο πλευρές χρησιμοποιούν ΑΙ, η ίδια ταχύτητα θα μπορούσε να προσθέσει πίεση για να ενεργήσουν γρήγορα (και να σκεφτούν αργότερα), ώστε ν’ αποφύγουν να ξεγελαστούν.

Η πυρηνική αποτροπή με τη βοήθεια της ΑΙ θα ήταν επίσης δίκοπο μαχαίρι: τα αυτόνομα συστήματα με πυρηνικό οπλισμό ίσως καταστήσουν δυσκολότερο για έναν επιτιθέμενο να εξουδετερώσει όλες τις πυρηνικές άμυνες ενός κράτους με μια κίνηση, μειώνοντας έτσι τα κίνητρα για ένα προληπτικό πρώτο πλήγμα.

Από την άλλη πλευρά, η πολυπλοκότητα των συστημάτων με τεχνητή νοημοσύνη ενέχει τον κίνδυνο αλυσιδωτών και δυνητικά καταστροφικών αποτυχιών.

Απρόβλεπτες συναντήσεις

Η συρροή αυτών των παραγόντων κινδύνου καθιστά τον καθορισμό της σωστής αντίδρασης σε περιστατικά που αφορούν συστήματα με τεχνητή νοημοσύνη και αυτόνομα συστήματα, μοναδικά πολύπλοκα και εξαρτώμενα από το ευρύτερο περιβάλλον.

Δεδομένου του πόσο δύσκολο θα είναι ν’ αντιμετωπιστεί αυτή η πολυπλοκότητα εν τη γενέσει της, τα κράτη πρέπει να βρουν εκ των προτέρων διόδους διαφυγής από πιθανές συγκρούσεις. Ευτυχώς, μπορούν να βασιστούν σε σχέδια από το παρελθόν.

Το 2020, περίπου το 90% των αμερικανικών αναγνωριστικών πτήσεων πάνω από τη Μαύρη Θάλασσα αναχαιτίστηκαν από ρωσικά αεροσκάφη, σύμφωνα με τον αμερικανικό στρατό. Το ΝΑΤΟ δήλωσε ότι είχε αναχαιτίσει ρωσικά αεροσκάφη σε περισσότερες από 300 περιπτώσεις το ίδιο έτος.

Τέτοιες αναχαιτίσεις δεν είναι καινούργιες, αποτελούν μια σύγχρονη εκδοχή της διπλωματίας των κανονιοφόρων του 19ου αιώνα. Ο όρος προέκυψε για να περιγράψει την τάση των δυτικών κρατών να χρησιμοποιούν φυσικές επιδείξεις ναυτικών μέσων για την προβολή ισχύος και τον εκφοβισμό άλλων εθνών ώστε να συμμορφωθούν με τις απαιτήσεις τους.

Λύσεις… από το παρελθόν

Καθώς η τεχνολογία εξελισσόταν, οι κανονιοφόροι έδωσαν τη θέση τους στ’ αεροπλανοφόρα, στη συνέχεια στα βομβαρδιστικά B-52, και αργότερα στα αεροσκάφη επιτήρησης E-3 Sentry AWACS και σ’ άλλες επιβλητικές καινοτομίες.

Η χρήση – και η αναχαίτιση – των ολοένα και πιο υψηλής τεχνολογίας συστημάτων με δυνατότητα τεχνητής νοημοσύνης είναι απλώς η τελευταία επανάληψη αυτής της τεχνο-τακτικής.

Οπως υποδηλώνει το όνομα, η διπλωματία των κανονιοφόρων χρησιμοποιείται για την επιδίωξη διπλωματικών και όχι στρατιωτικών στόχων.

Ομως, δεδομένων των εργαλείων που χρησιμοποιούνται, ο λάθος υπολογισμός και η κακή επικοινωνία μπορεί να έχουν ολέθριες συνέπειες. Τα κράτη το έχουν κατανοήσει από καιρό αυτό και έχουν βρει, στο παρελθόν, τρόπους να περιορίσουν τον κίνδυνο ακούσιας κλιμάκωσης.

Ενας από τους πιο αποτελεσματικούς μηχανισμούς του είδους προέκυψε κατά τη διάρκεια του Ψυχρού Πολέμου. Εκείνη την εποχή, η Σοβιετική Ενωση αντιδρούσε στις ναυτικές επιχειρήσεις των ΗΠΑ σε ύδατα που θεωρούσε δικά της, όπως η Μαύρη Θάλασσα και η Θάλασσα της Ιαπωνίας.

Ευτυχώς, τα κράτη μπορούν να βασιστούν σε σχέδια από το παρελθόν για να βρουν διόδους διαφυγής από πιθανές συγκρούσεις (εικόνα Bratishko Konstantin on Shutterstock)

Κατέστησε σαφή τη θέση της αναχαιτίζοντας επανειλημμένα και με επιθετικό τρόπο αμερικανικά σκάφη, οδηγώντας σε μια σειρά επικίνδυνων οριακών συγκρούσεων.

Μέχρι τις αρχές της δεκαετίας του 1970, οι Ηνωμένες Πολιτείες και η Σοβιετική Ενωση είχαν φτάσει ν’ αναγνωρίζουν ότι «οι κίνδυνοι της ναυτικής παρενόχλησης υπονομεύουν κάθε δικαιολογία για τη συνέχιση της απεριόριστης πρακτικής της», όπως έγραψε λίγα χρόνια αργότερα ο μελετητής Sean Lynn-Jones.

Η συμφωνία INCSEA

Αυτή η αμοιβαία διαπίστωση οδήγησε, το 1972, στη Συμφωνία για τα Περιστατικά στη Θάλασσα (Incidents at Sea Agreement, INCSEA) μεταξύ ΗΠΑ και Σοβιετικής Ενωσης.

Η συμφωνία INCSEA, όπως έγινε γνωστή, κάλυπτε κάθε αλληλεπίδραση μεταξύ αμερικανικών και σοβιετικών στρατιωτικών σκαφών στην ανοικτή θάλασσα, από τις σκόπιμες αντιπαραθέσεις έως τις απρογραμμάτιστες συναντήσεις.

Καθιέρωσε πρωτόκολλα ειδοποίησης και διαδικασίες ανταλλαγής πληροφοριών που αποσκοπούσαν στη μείωση του κινδύνου ατυχημάτων και ακούσιων συγκρούσεων.

Ηδη από το 1983, το Πολεμικό Ναυτικό των ΗΠΑ δήλωσε ότι η συμφωνία ήταν επιτυχής, διότι μείωσε τον αριθμό των επιθετικών αλληλεπιδράσεων στην ανοικτή θάλασσα, ακόμη και όταν το αμερικανικό και το σοβιετικό ναυτικό είχαν και τα δύο επεκταθεί σε μέγεθος.

Οπως και άλλα μέτρα οικοδόμησης εμπιστοσύνης, η συμφωνία δεν περιόριζε τις στρατιωτικές επιχειρήσεις ή τις δομές των δυνάμεων. Ούτε εξάλειψε ούτε μεταμόρφωσε ριζικά τον ανταγωνισμό ΗΠΑ – Σοβιετικής Ενωσης στον ναυτικό τομέα. Εκανε, ωστόσο, τον ανταγωνισμό πιο προβλέψιμο και ασφαλέστερο.

Η επιτυχία της συμφωνίας INCSEA άνοιξε τον δρόμο για παρόμοιους μηχανισμούς στην ανοικτή θάλασσα και πέραν αυτής. Η Σοβιετική Ενωση και, αργότερα, η Ρωσία αναπαρήγαγαν τη συμφωνία με 11 μέλη του ΝΑΤΟ και αρκετές χώρες του Ινδο-Ειρηνικού.

Πρόσθετες συμφωνίες ΗΠΑ – Σοβιετικής Ενωσης περιλάμβαναν παρόμοια πρωτόκολλα για συναντήσεις στην ξηρά και στον αέρα. Πιο πρόσφατα, η Κίνα και οι Ηνωμένες Πολιτείες ανέπτυξαν έναν μη δεσμευτικό Κώδικα για απρογραμμάτιστες συναντήσεις στη θάλασσα, τον οποίο τηρούν πλέον οι ίδιες και σχεδόν 20 άλλα κράτη. Εχουν γίνει ακόμη και συζητήσεις για την επέκταση παρόμοιων μηχανισμών στο διάστημα και στον κυβερνοχώρο.

Οι κανόνες στη διαδρομή

Σίγουρα, μια συμφωνία όπως η INCSEA εφαρμόζεται τεχνικά είτε υπάρχει πλήρωμα επί του σκάφους είτε όχι, αλλά τελικά προϋποθέτει ότι οι ανθρώπινοι χειριστές έχουν τον έλεγχο.

Οι μοναδικές προκλήσεις που παρουσιάζουν τα συστήματα με τεχνητή νοημοσύνη και τα αυτόνομα συστήματα απαιτούν πιο προσαρμοσμένες λύσεις. Σκεφτείτε το ως μια συμφωνία INCSEA για την εποχή της τεχνητής νοημοσύνης: μια Συμφωνία για Αυτόνομα Περιστατικά (Autonomous Incidents Agreement).

Το πρώτο εμπόδιο για οποιαδήποτε τέτοια συμφωνία είναι η δυσκολία ανάλυσης του νοήματος και της πρόθεσης πίσω από την συμπεριφορά ενός συστήματος με τεχνητή νοημοσύνη.

Στην πορεία, ίσως καταστεί δυνατή η παρακολούθηση και η επαλήθευση των εσωτερικών λειτουργιών και του κώδικα αυτών των συστημάτων, γεγονός που θα μπορούσε να προσφέρει μεγαλύτερη διαφάνεια σχετικά με τον τρόπο λήψης των αποφάσεών τους.

Αλλά ως προσωρινό μέτρο, μια Συμφωνία για αυτόνομα περιστατικά θα μπορούσε να ξεκινήσει με τη ρύθμιση όχι του κώδικα της ΑΙ αλλά της συμπεριφοράς της ΑΙ – θέτοντας κανόνες και πρότυπα για την αναμενόμενη συμπεριφορά τόσο για την ΑΙ και τα αυτόνομα συστήματα όσο και για τους στρατούς που τα χρησιμοποιούν.

Ο χρόνος είναι ώριμος

Τα στοιχεία μιας τέτοιας συμφωνίας θα μπορούσαν να είναι τόσο απλά όσο η απαίτηση να παραχωρούν τα αυτόνομα αεροσκάφη και τα αεροσκάφη με τεχνητή νοημοσύνη το δικαίωμα διέλευσης σε μη αυτόνομα αεροσκάφη (όπως απαιτούν ήδη οι κανόνες της Ομοσπονδιακής Υπηρεσίας Πολιτικής Αεροπορίας για τα μη επανδρωμένα εμπορικά drones και τα drones αναψυχής).

Η συμφωνία θα μπορούσε επίσης να απαιτεί από τα συστήματα με δυνατότητα τεχνητής νοημοσύνης να παραμένουν σε ορισμένη απόσταση από άλλες οντότητες. Θα μπορούσε να θέσει διατάξεις κοινοποίησης και ειδοποίησης για να διασφαλίσει τη διαφάνεια σχετικά με το ποιος αναπτύσσει τι.

Τέτοιες διατάξεις ίσως να φαίνονται προφανείς, αλλά δεν θα ήταν περιττές. Η εκ των προτέρων περιγραφή τους θα έθετε μια βάση για την αναμενόμενη συμπεριφορά. Οποιαδήποτε ενέργεια από ένα σύστημα τεχνητής νοημοσύνης εκτός αυτών των παραμέτρων θα αποτελούσε μια ξεκάθαρη παραβίαση.

Επιπλέον, αυτές οι παράμετροι θα διευκόλυναν την επισήμανση περιπτώσεων στις οποίες ένα σύστημα με ΑΙ παρεκκλίνει από την αναμενόμενη συμπεριφορά του, ακόμη και αν δεν είναι τεχνικά εφικτό να προσδιοριστεί η ακριβής αιτία εκ των υστέρων.

Ο χρόνος για μια συμφωνία σχετική με τα αυτόνομα περιστατικά είναι ώριμος, δεδομένου ότι η τεχνητή νοημοσύνη βρίσκεται σε σημείο καμπής. Από τη μια πλευρά, η τεχνολογία ωριμάζει και γίνεται όλο και πιο κατάλληλη για στρατιωτική χρήση, είτε στο πλαίσιο ασκήσεων πολεμικών παιγνίων είτε σε μάχη, όπως στην Ουκρανία.

Το πραγματικό ερώτημα

Από την άλλη πλευρά, τα ακριβή περιγράμματα των μελλοντικών στρατιωτικών συστημάτων τεχνητής νοημοσύνης – και ο βαθμός διαταραχής που θα προκαλέσουν – παραμένουν αβέβαια και, κατ’ επέκταση, κάπως εύπλαστα.

Τα κράτη που είναι πρόθυμα ν’ αναλάβουν την πρωτοβουλία θα μπορούσαν ν’ αξιοποιήσουν την υπάρχουσα δυναμική για αυστηρότερους κανόνες. Ο ιδιωτικός τομέας φαίνεται πρόθυμος να αυτορρυθμίσει τουλάχιστον σε ορισμένο βαθμό την ανάπτυξη της τεχνητής νοημοσύνης.

Και ως απάντηση σε αιτήματα των κρατών-μελών, ο Διεθνής Οργανισμός Πολιτικής Αεροπορίας (International Civil Aviation Organization, ICAO) εργάζεται πάνω σ’ ένα πρότυπο ρυθμιστικό πλαίσιο για τα συστήματα αεροσκαφών χωρίς πλήρωμα και έχει ενθαρρύνει τα κράτη να μοιραστούν υφιστάμενους κανονισμούς και βέλτιστες πρακτικές.

Μια Συμφωνία για Αυτόνομα Περιστατικά θα έθετε αυτές τις εκκολαπτόμενες προσπάθειες σε στέρεες βάσεις. Η ανάγκη για σαφέστερους κανόνες, για έναν βασικό μηχανισμό ευθύνης και λογοδοσίας, είναι τόσο μεγάλη όσο και επείγουσα.

Το ίδιο και η ανάγκη για ένα πρωτόκολλο χειρισμού των διακρατικών αψιμαχιών που αφορούν σ’ αυτά τα συστήματα αιχμής. Τα κράτη θα πρέπει ν’ αρχίσουν να προετοιμάζονται τώρα, καθώς το πραγματικό ερώτημα σχετικά με τέτοια περιστατικά δεν είναι αν θα συμβούν, αλλά το πότε.

Πηγή: in.gr

Latest News

Στις συμπληγάδες ΗΠΑ - Κίνας ο γίγαντας των ημιαγωγών Nvidia - Τι ζητά ο Χουάνγκ στο Πεκίνο;

Ο Τζένσεν Χουάνγκ, CEO της Nvidia, θα απαιτήσει άδειες για να εξάγει το μικροτσίπ H20 AI στην Κίνα

Ιταλική εφημερίδα δημοσίευσε ένθετο γραμμένο από ΑΙ

Μετά τον πρώτο μήνα δοκιμών, η ιταλική εφημερίδα Il Foglio προσέλαβε το σύστημα ως μόνιμο υπάλληλο.

Η Δικαιοσύνη αναβαθμίζεται ψηφιακά με συστήματα AI

Μέχρι σήμερα, η μετάφραση εκατοντάδων, αν όχι χιλιάδων, σελίδων και η αναζήτηση διαθέσιμων μεταφραστών και διερμηνέων, ειδικά σε κάποιες γλώσσες, προκαλεί σημαντικές καθυστερήσεις

Ξεκινά η υλοποίηση του ελληνικού εργοστασίου τεχνητής νοημοσύνης

Το AI Factory «Pharos» είναι ένα από τα πρώτα δεκατρία «εργοστάσια» Τεχνητής Νοημοσύνης στην Ευρώπη

Η TDK φέρνει επανάσταση στη δημιουργική ΑΙ

Η TDK κατέγραψε χρόνους απόκρισης 20 τρισεκατομμυρίων του δευτερολέπτου στη δοκιμή για τη βελτίωση των ταχυτήτων μεταφοράς δεδομένων

Ξεπέρασαν τις 15.000 οι επισκέπτες στη Beyond 2025

Η BEYOND 2025 συγκέντρωσε περισσότερους από 300 εκθέτες από την Ελλάδα και από 10 χώρες

Οι start-ups που δημιουργούν εργαλεία παραγωγικότητας είναι το νέο μεγάλο στοίχημα της ΑΙ - Ποιες είναι

Οι επενδυτές ποντάρουν σε AI startups που αναπτύσσουν πρακτικές εφαρμογές της ΑΙ αναζητώντας μεγάλα κέρδη χωρίς τεράστιες δαπάνες

Τα 5 πράγματα που δεν πρέπει να μοιράζεστε ποτέ με την τεχνητή νοημοσύνη

To ChatGPT, όπως και άλλα εργαλεία τεχνητής νοημοσύνης, εξελίσσονται χρησιμοποιούνται από όλο και περισσότερους ανθρώπους για μια ευρεία γκάμα αναζητήσεων

Ποιες είναι οι 10 χώρες με τα περισσότερα ταλέντα στην AI

Έρευνα της Microsoft, με τη συμμετοχή 31.000 ατόμων σε 31 χώρες, έδειξε ότι το 66% των επιχειρήσεων δεν θα προσλάμβανε κάποιον χωρίς δεξιότητες στην τεχνητή νοημοσύνη

Η συμβολή της ΑΙ στην κατανόηση της σεισμικής κρίσης στη Σαντορίνη

Τα πρώτα αποτελέσματα της χρήση υψηλής τεχνολογίας και τεχνητής νοημοσύνης στην παρακολούθηση της σεισμικής δραστηριότητας στη Σαντορίνη

![Πλημμύρες: Σημειώθηκαν σε επίπεδα ρεκόρ στην Ευρώπη το 2024 [γράφημα]](https://www.ot.gr/wp-content/uploads/2025/04/FLOOD_HUNGRY-90x90.jpg)

![Airbnb: Πτωτικά κινήθηκε η ζήτηση τον Μάρτιο – Τι δείχνουν τα στοιχεία [γράφημα]](https://www.ot.gr/wp-content/uploads/2024/07/airbnb-gba8e58468_1280-1-90x90.jpg)

![Airbnb: Πτωτικά κινήθηκε η ζήτηση τον Μάρτιο – Τι δείχνουν τα στοιχεία [γράφημα]](https://www.ot.gr/wp-content/uploads/2024/07/airbnb-gba8e58468_1280-1-600x500.jpg)

Αριθμός Πιστοποίησης

Αριθμός Πιστοποίησης