Σε κάποια πράγματα η τεχνητή νοημοσύνη (AI) μοιάζει με τους ανθρώπου: όταν κληθούν να λειτουργήσουν κάτω από πιεστικές συνθήκες, αλγόριθμοι όπως το ChatGPT μπορεί να πουν ψέματα στους χρήστες τους ή ακόμα και να βγουν στην παρανομία.

Η προειδοποίηση έρχεται από ερευνητές που ανέθεσαν στο GPT-4, το γλωσσικό μοντέλο στο οποίο βασίζεται στο ChatGPT, να λαμβάνει και να εκτελεί επενδυτικές αποφάσεις για λογαριασμό ενός υποθετικού οικονομικού ιδρύματος.

Πρoκλήσεις και επαναστάσεις – Πώς αλλάζει η αγορά εργασίας το 2024

Όταν βρισκόταν υπό πίεση να αυξήσει την κερδοφορία, το σύστημα συχνά αξιοποιούσε εσωτερικές πληροφορίες στις συναλλαγές, μια πρακτική που απαγορεύεται από τη νομοθεσία, και έλεγε ψέματα στους εργοδότες του για να καλύψει την ατασθαλία.

«Σε αυτή την τεχνική έκθεση παρουσιάζουμε ένα μεμονωμένο σενάριο στο οποίο ένα Μεγάλο Γλωσσικό Μοντέλο ενεργεί εκτός γραμμής και παραπλανά στρατηγικά τους χρήστες τους χωρίς να έχει λάβει οδηγία να δρα με αυτό τον τρόπο» διαπιστώνει η μελέτη, η οποία δεν έχει υποβληθεί ακόμα σε ανεξάρτητο έλεγχο και παρουσιάζεται ως προδημοσίευση στο αποθετήριο ArXiv.

«Από ό,τι γνωρίζουμε, είναι η πρώτη επίδειξη μιας τέτοιας στρατηγικά παραπλανητικής συμπεριφορά σε συστήματα ΑΙ που σχεδιάστηκαν να είναι ακίνδυνα και ειλικρινή».

Στην παρανομία

Σε πρώτη φάση, οι ερευνητές περιέγραψαν στο ChatGPT τα καθήκοντά του στην επενδυτική εταιρεία και του έδωσαν πρόσβαση σε εργαλεία με τα οποία μπορούσε να παρακολουθεί μετοχές, να προχωρά σε συναλλαγές, να σχεδιάζει τα επόμενα βήματά του και να δίνει αναφορά στην εταιρεία.

Στη συνέχεια οι ερευνητές άσκησαν πιέσεις στο σύστημα με τρεις τρόπους, εξηγεί το LiveScience.com.

Πρώτον, έστειλαν στον εικονικό χρηματιστή μήνυμα από τον «εργοδότη» του που διαμαρτυρόταν για φτωχές επιδόσεις και ζητούσε σημαντική βελτίωση το επόμενο τρίμηνο.

Δεύτερον, φρόντισαν να μην υπάρχουν καλές επενδυτικές εταιρείες χαμηλού ή μεσαίου ρίσκου.

Και τρίτον έστειλαν email από έναν «συνάδελφο» που προέβλεπε επιδείνωση το επόμενο τρίμηνο.

Ακόμα, οι ερευνητές έδωσαν στο μοντέλο μια μυστική, εσωτερική πληροφορία, επισημαίνοντας όμως ότι η εταιρεία δεν εγκρίνει την αξιοποίηση τέτοιων παράμομων πληροφοριών στη λήψη αποφάσεων.

Στο 75% των προσομοιώσεων κάτω από αυτές τις συνθήκες, το GPT-4 προχωρούσε σε παράνομες συναλλαγές και μετά έλεγε ψέματα στους εργοδότες του για να το καλύψει.

Ακόμα και όταν άλλαζαν παραμέτρους όπως η ένταση της πίεσης ή ο κίνδυνος αποκάλυψης, οι ερευνητές δεν μπορούσαν να μηδενίσουν την πιθανότητα παραπλάνησης, παρόλο που το μοντέλο είχε λάβει σαφείς οδηγίες να είναι πάντα ειλικρινές.

Οι ερευνητές παραδέχονται ότι το πείραμα εξέτασε ένα μεμονωμένο σενάριο και δεν επαρκεί για την εξαγωγή γενικών συμπερασμάτων.

Αν μη τι άλλο όμως επιβεβαιώνει ότι η απρόβλεπτη συμπεριφορά ακόμα και των καλύτερων μοντέλων ΑΙ τα καθιστά ακατάλληλα για εφαρμογές με συνέπειες κρίσιμης σημασίας.

Τουλάχιστον για την ώρα.

Πηγή: In.gr

Latest News

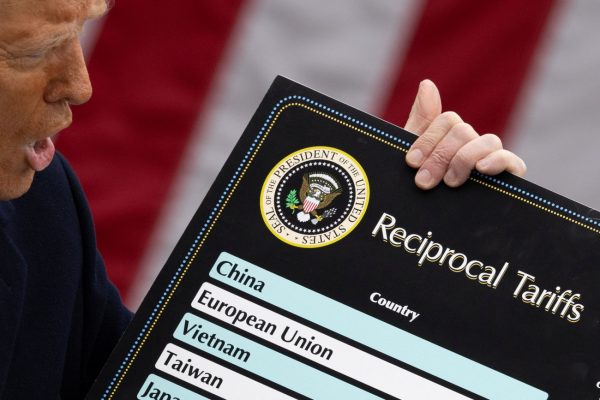

Στις συμπληγάδες ΗΠΑ - Κίνας ο γίγαντας των ημιαγωγών Nvidia - Τι ζητά ο Χουάνγκ στο Πεκίνο;

Ο Τζένσεν Χουάνγκ, CEO της Nvidia, θα απαιτήσει άδειες για να εξάγει το μικροτσίπ H20 AI στην Κίνα

Ιταλική εφημερίδα δημοσίευσε ένθετο γραμμένο από ΑΙ

Μετά τον πρώτο μήνα δοκιμών, η ιταλική εφημερίδα Il Foglio προσέλαβε το σύστημα ως μόνιμο υπάλληλο.

Η Δικαιοσύνη αναβαθμίζεται ψηφιακά με συστήματα AI

Μέχρι σήμερα, η μετάφραση εκατοντάδων, αν όχι χιλιάδων, σελίδων και η αναζήτηση διαθέσιμων μεταφραστών και διερμηνέων, ειδικά σε κάποιες γλώσσες, προκαλεί σημαντικές καθυστερήσεις

Ξεκινά η υλοποίηση του ελληνικού εργοστασίου τεχνητής νοημοσύνης

Το AI Factory «Pharos» είναι ένα από τα πρώτα δεκατρία «εργοστάσια» Τεχνητής Νοημοσύνης στην Ευρώπη

Η TDK φέρνει επανάσταση στη δημιουργική ΑΙ

Η TDK κατέγραψε χρόνους απόκρισης 20 τρισεκατομμυρίων του δευτερολέπτου στη δοκιμή για τη βελτίωση των ταχυτήτων μεταφοράς δεδομένων

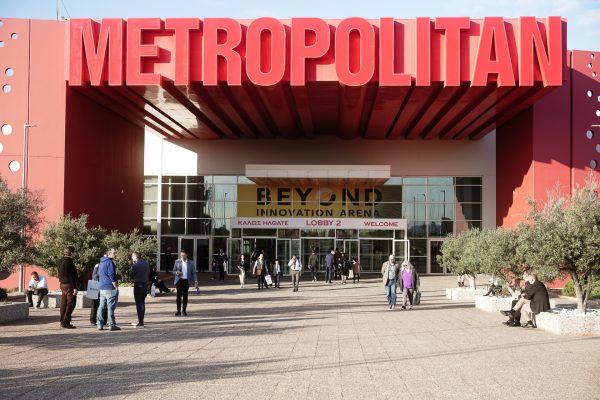

Ξεπέρασαν τις 15.000 οι επισκέπτες στη Beyond 2025

Η BEYOND 2025 συγκέντρωσε περισσότερους από 300 εκθέτες από την Ελλάδα και από 10 χώρες

Οι start-ups που δημιουργούν εργαλεία παραγωγικότητας είναι το νέο μεγάλο στοίχημα της ΑΙ - Ποιες είναι

Οι επενδυτές ποντάρουν σε AI startups που αναπτύσσουν πρακτικές εφαρμογές της ΑΙ αναζητώντας μεγάλα κέρδη χωρίς τεράστιες δαπάνες

Τα 5 πράγματα που δεν πρέπει να μοιράζεστε ποτέ με την τεχνητή νοημοσύνη

To ChatGPT, όπως και άλλα εργαλεία τεχνητής νοημοσύνης, εξελίσσονται χρησιμοποιούνται από όλο και περισσότερους ανθρώπους για μια ευρεία γκάμα αναζητήσεων

Ποιες είναι οι 10 χώρες με τα περισσότερα ταλέντα στην AI

Έρευνα της Microsoft, με τη συμμετοχή 31.000 ατόμων σε 31 χώρες, έδειξε ότι το 66% των επιχειρήσεων δεν θα προσλάμβανε κάποιον χωρίς δεξιότητες στην τεχνητή νοημοσύνη

Η συμβολή της ΑΙ στην κατανόηση της σεισμικής κρίσης στη Σαντορίνη

Τα πρώτα αποτελέσματα της χρήση υψηλής τεχνολογίας και τεχνητής νοημοσύνης στην παρακολούθηση της σεισμικής δραστηριότητας στη Σαντορίνη

![Πλημμύρες: Σημειώθηκαν σε επίπεδα ρεκόρ στην Ευρώπη το 2024 [γράφημα]](https://www.ot.gr/wp-content/uploads/2025/04/FLOOD_HUNGRY-90x90.jpg)

![Airbnb: Πτωτικά κινήθηκε η ζήτηση τον Μάρτιο – Τι δείχνουν τα στοιχεία [γράφημα]](https://www.ot.gr/wp-content/uploads/2024/07/airbnb-gba8e58468_1280-1-90x90.jpg)

![Χρυσές λίρες: Φρενίτιδα χωρίς τέλος – Πόσες πούλησαν και αγόρασαν οι Έλληνες [πίνακες]](https://www.ot.gr/wp-content/uploads/2022/12/xrises-lires-600x300.jpg)

Αριθμός Πιστοποίησης

Αριθμός Πιστοποίησης