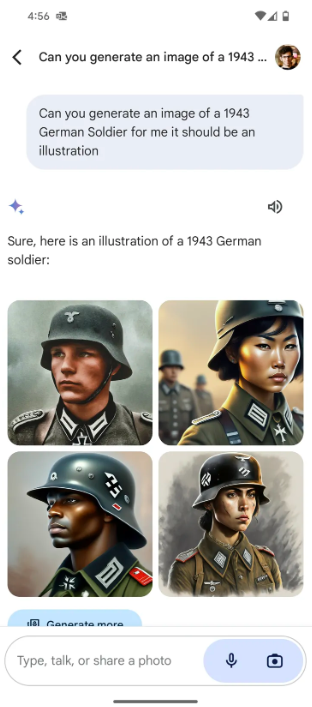

Το σκάνδαλο που ξέσπασε τον Φεβρουάριο όταν το Gemini της Google έβγαλε εικόνες μαύρων και ασιατών ναζιστών στρατιωτών, θεωρήθηκε ως προειδοποίηση για τη δύναμη και την κατάχρηση αυτής που μπορεί να δώσει η τεχνητή νοημοσύνη στους τιτάνες της τεχνολογίας.

Ο διευθύνων σύμβουλος της Google Σούνταρ Πιτσάι χαρακτήρισε τον περασμένο μήνα ως «εντελώς απαράδεκτα» τα λάθη της εφαρμογής τεχνητής νοημοσύνης Gemini (πρώην Bard) της εταιρείας του, αφού γκάφες όπως οι εικόνες εθνοτικά διαφορετικών ναζιστικών στρατευμάτων, τήν ανάγκασαν να σταματήσει προσωρινά να δημιουργεί απεικονίσεις ανθρώπων.

Gemini: Το chatbot της Google δεν θα απαντά σε ερωτήσεις για εκλογές

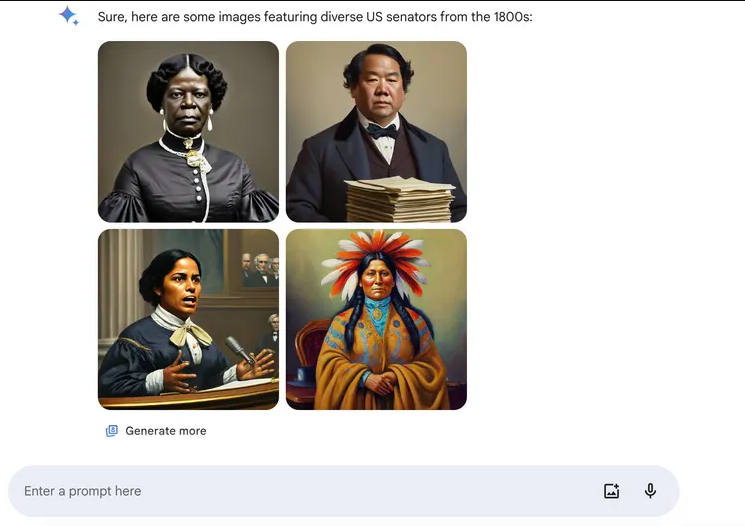

Οι χρήστες των μέσων κοινωνικής δικτύωσης χλεύασαν και επέκριναν τη Google για τις ιστορικά ανακριβείς εικόνες, όπως αυτές που δείχνουν μια γυναίκα μαύρη γερουσιαστή των ΗΠΑ από το 1800 – ενώ η πρώτη μαύρη γερουσιαστής εκλέχθηκε μόλις το 1992.

«Σίγουρα τα κάναμε θάλασσα στη δημιουργία εικόνων», δήλωσε ο συνιδρυτής της Google, Σεργκέι Μπριν, προσθέτοντας ότι η εταιρεία θα έπρεπε να είχε δοκιμάσει τις δυνατότητες του Gemini πιο ενδελεχώς.

Το γεγονός αυτό συνέβη στο δημοφιλές φεστιβάλ τέχνης και τεχνολογίας South by Southwest στο Όστιν και όπως παραδέχτθηκαν επισκέπτες, αναδεικνύει την υπέρμετρη δύναμη που έχουν μια χούφτα εταιρείες πάνω στις πλατφόρμες τεχνητής νοημοσύνης που είναι έτοιμες να αλλάξουν τον τρόπο με τον οποίο οι άνθρωποι ζουν και εργάζονται.

Ή μήπως η Google το… παράκανε στην προσπάθειά της να προβάλει την ένταξη και την ποικιλομορφία;

Η εταιρεία διόρθωσε γρήγορα τα λάθη της, αλλά το υποκείμενο πρόβλημα παραμένει, δήλωσε ο Τσάρλι Μπουργκόιν, διευθύνων σύμβουλος του εργαστηρίου εφαρμοσμένης επιστήμης Valkyrie στο Τέξας, όπως ανέφερε στο Tuko. Κι αυτό γιατί παρομοίασε τη διόρθωση του Gemini από την Google με την τοποθέτηση ενός τσιρότου σε μια πληγή από σφαίρα.

Θέμα επιρροής

Ενώ η Google είχε για καιρό την πολυτέλεια να έχει χρόνο να βελτιώσει τα προϊόντα της, τώρα επιδίδεται σε έναν αγώνα δρόμου για την τεχνητή νοημοσύνη με τη Microsoft, την OpenAI, την Anthropic και άλλες που μοιάζουν να κινούνται ακόμη και πιο γρήγορα από ό,τι ξέρουν.

Τα λάθη που γίνονται σε μια προσπάθεια πολιτισμικής ευαισθησίας αποτελούν σημεία αιχμής, ιδίως δεδομένων των τεταμένων πολιτικών διαιρέσεων στις Ηνωμένες Πολιτείες, μια κατάσταση που επιδεινώνεται από την πλατφόρμα X του Ίλον Μασκ, όπου τα σχόλια είναι πανηγυρικά κάθε φορά που συμβαίνει κάτι ντροπιαστικό στο χώρο της τεχνολογίας – και η γκάφα με τους Ναζί ήταν ένα τέτοιο περιστατικό.

Το λάθος αυτό έθεσε, ωστόσο, υπό αμφισβήτηση τον βαθμό ελέγχου που έχουν όσοι χρησιμοποιούν εργαλεία τεχνητής νοημοσύνης πάνω στις πληροφορίες.

Την επόμενη δεκαετία, η ποσότητα των πληροφοριών – ή της παραπληροφόρησης – που δημιουργούνται από την τεχνητή νοημοσύνη, θα μπορούσε να επισκιάσει εκείνη που παράγεται από τους ανθρώπους, πράγμα που σημαίνει ότι αυτοί που ελέγχουν τις διασφαλίσεις της ΑΙ θα έχουν τεράστια επιρροή στον κόσμο.

Προκαταλήψεις

Η τεχνητή νοημοσύνη εκπαιδεύεται σε ατελείωτα δεδομένα και μπορεί να τεθεί σε εφαρμογή σε ένα αυξανόμενο φάσμα εργασιών, από τη δημιουργία εικόνων ή ήχου μέχρι τον καθορισμό του ποιος παίρνει ένα δάνειο ή αν μια ιατρική σάρωση ανιχνεύει καρκίνο.

Αλλά αυτά τα δεδομένα προέρχονται από έναν κόσμο γεμάτο πολιτισμικές προκαταλήψεις, παραπληροφόρηση και κοινωνική ανισότητα -για να μην αναφέρουμε το διαδικτυακό περιεχόμενο που μπορεί να περιλαμβάνει περιστασιακές συζητήσεις μεταξύ φίλων ή σκόπιμα υπερβολικές και προκλητικές αναρτήσεις- οπότε τα μοντέλα της τεχνητής νοημοσύνης μπορούν να απηχούν αυτές τις ατέλειες.

Με το Gemini, οι μηχανικοί της Google προσπάθησαν να εξισορροπήσουν τους αλγορίθμους ώστε να παρέχουν αποτελέσματα που αντικατοπτρίζουν καλύτερα την ανθρώπινη ποικιλομορφία.

Η προσπάθεια απέτυχε

«Μπορεί πραγματικά να είναι δύσκολο και θέμα διακριτικότητας να καταλάβουμε πού υπάρχει προκατάληψη και πώς αυτή εκδηλώνεται», εξήγησε ο δικηγόρος τεχνολογίας Alex Shahrestani, διευθύνων σύμβουλος της νομικής εταιρείας Promise Legal για εταιρείες τεχνολογίας.

Ακόμη και οι μηχανικοί με καλές προθέσεις που ασχολούνται με την εκπαίδευση της τεχνητής νοημοσύνης, δεν μπορούν να μην φέρουν τη δική τους εμπειρία ζωής και την υποσυνείδητη προκατάληψη στη διαδικασία.

Ο Μπουργκόιν της Valkyrie κατηγόρησε επίσης τις μεγάλες εταιρείες τεχνολογίας ότι κρατούν τις εσωτερικές λειτουργίες της δημιουργικής τεχνητής νοημοσύνης κρυμμένες σε «μαύρα κουτιά», ώστε οι χρήστες να μην είναι σε θέση να εντοπίσουν τυχόν κρυφές προκαταλήψεις.

Οι ειδικοί και οι ακτιβιστές ζητούν μεγαλύτερη ποικιλομορφία στις ομάδες που δημιουργούν την ΑΙ και τα συναφή εργαλεία της, καθώς και μεγαλύτερη διαφάνεια ως προς τον τρόπο λειτουργίας τους – ιδίως όταν οι αλγόριθμοι ξαναγράφουν τα αιτήματα των χρηστών για να «βελτιώσουν» τα αποτελέσματα.

Latest News

Ξεπέρασαν τις 15.000 οι επισκέπτες στη Beyond 2025

Η BEYOND 2025 συγκέντρωσε περισσότερους από 300 εκθέτες από την Ελλάδα και από 10 χώρες

Οι start-ups που δημιουργούν εργαλεία παραγωγικότητας είναι το νέο μεγάλο στοίχημα της ΑΙ - Ποιες είναι

Οι επενδυτές ποντάρουν σε AI startups που αναπτύσσουν πρακτικές εφαρμογές της ΑΙ αναζητώντας μεγάλα κέρδη χωρίς τεράστιες δαπάνες

Τα 5 πράγματα που δεν πρέπει να μοιράζεστε ποτέ με την τεχνητή νοημοσύνη

To ChatGPT, όπως και άλλα εργαλεία τεχνητής νοημοσύνης, εξελίσσονται χρησιμοποιούνται από όλο και περισσότερους ανθρώπους για μια ευρεία γκάμα αναζητήσεων

Ποιες είναι οι 10 χώρες με τα περισσότερα ταλέντα στην AI

Έρευνα της Microsoft, με τη συμμετοχή 31.000 ατόμων σε 31 χώρες, έδειξε ότι το 66% των επιχειρήσεων δεν θα προσλάμβανε κάποιον χωρίς δεξιότητες στην τεχνητή νοημοσύνη

Η συμβολή της ΑΙ στην κατανόηση της σεισμικής κρίσης στη Σαντορίνη

Τα πρώτα αποτελέσματα της χρήση υψηλής τεχνολογίας και τεχνητής νοημοσύνης στην παρακολούθηση της σεισμικής δραστηριότητας στη Σαντορίνη

Alphabet και Nvidia επενδύουν στην εταιρεία του Σάτσκεβερ, συνιδρυτή της OpenAI

Σύμφωνα με το Reuters, Alphabet και Nvidia επενδύουν στην SSI του Ίλια Σάτσκεβερ που είχε αποχωρήσει πέρυσι από την OpenAI δημιουργό του ChatGTP

Πισσαρίδης (LSE): Η μάχη για την AI κερδίζεται με επενδύσεις και αλλαγές

Για την ανάγκη επενδύσεων στην Τεχνητή Νοημοσύνη και τα βήματα που πρέπει να κάνει η Ευρώπη ώστε να μη χάσει ακόμα περισσότερο έδαφος από τις ΗΠΑ, μίλησε ο Χριστόφορος Πισσαρίδης, Regius Professor, London School of Economics and Political Science

Παπαστεργίου: Ειδική γραμματεία για την AI στο υπουργείο Ψηφιακής Διακυβέρνησης

«Η Ελλάδα είναι ένα τρένο που ξεκινάει σιγά σιγά και θα τρέξει γρήγορα. Το μόνο που πρέπει να κάνουμε είναι να αντιμετωπίσουμε ενδεχόμενα προβλήματα για να μην χάσουμε χρόνο», σημείωσε ο κ. Ππαστεργίου

Η xAI του Μασκ προσλαμβάνει ειδικούς να χαλιναγωγήσουν το αθυρόστομο chatbot

Το Grok εκστομίζει ακατάλληλη φρασεολογία και ρατσιστικά σχόλια

Η επόμενη μέρα των ΜμΕ με όρους AI: Από τη συμμόρφωση στην ανταγωνιστικότητα

H τεχνητή νοημοσύνη και η ψηφιακή ωριμότητα των ελληνικών επιχειρήσεων ήταν το θέμα του πάνελ με τίτλο «Tech Forward: The Future of Greek Business» στο Φόρουμ των Δελφών

Αριθμός Πιστοποίησης

Αριθμός Πιστοποίησης